ChatGPT macht Furore und wird euphorisch als Siegeszug der KI gefeiert. Zweifellos hat dieser Chatbot der neuen Generation viele Stärken und kann hilfreich sein. Nur einmal mehr wird, wie schon bei der Digitalisierung, auch diese KI-Innovation unkritisch gehypt. Welches die zahlreichen Gefahren und Risiken sind und wo Vorsicht geboten ist, verrät dieser Beitrag.

Viele dieser Fragen betreffen direkt und indirekt auch das Human Resource Management. Man denke nur an Selektionsverfahren, das Recruiting, Stellenbeschreibungen, Arbeitszeugnisse, Kündigungen, People Analytics, Job-Interviews, Mitarbeiter- und Analysedaten und viele Bereiche mehr. Es geht uns in diesem Beitrag nicht darum, die KI-Technologie zu verteufeln, sondern darum, dem Hype mit der dringend notwendigen kritischen Distanz zu begegnen und vor immensen Gefahren und Risiken zu warnen, welche diese Technologie eben auch birgt.

Die Gefahren und Risiken von ChatGPT

- Warum stellt niemand die Frage nach der Berechtigung, mit Daten und Wissen anderer zu handeln und diese zu verwerten (Urheberrecht)? Nichts anderes macht ChatGPT nämlich

- Was tut man dagegen, bei wichtigen Fragen und Problemen nicht mehr zu wissen, ob Informationen nun von Menschen oder von Chat GPT stammen?

- Das individuelle Wissen verliert an Wert, es wird kollektiviert

- Kann es nicht auch sein, dass vor allem junge Menschen das Lernen verlernen?

- Gefährdet ist auch der Journalismus, der versucht sein wird, zu so generierten Texten zu greifen

- Was tut der Staat und die Techbranche zur Einschränkung der Anwendungsgebiete?

- Wer haftet für falsche oder irreführende Antworten und Informationen – die Techkonzene, die Programmierer oder die ChatGPT-Anwender, die sie veröffentlichen?

- Warum fordern viel zu wenige die Transparenz, woher die Daten kommen und wie sie aufbereitet werden?

- Es besteht die Gefahr, die Urteilsfähigkeit zu verlieren, indem man sich nur noch auf Antworten von Chat GPT verlässt.

- Chat GPT entpuppt sich schon jetzt bei gewissen Themen als Fake-News-Schleuder

- Chat GPT könnte auch als Waffe missbraucht werden, um das Vertrauen in Rechtsstaatlichkeit und letztlich in die Demokratie zu zerstören.

- Eine solches Instrument privaten Techkonzernen zu überlassen, ist fahrlässig und unverantwortlich, vor allem wenn zweifelhafte Personen wie Musk involviert sind.

- ChatGPT verfügt über keinerlei manchmal eminent wichtige Fähigkeiten wie Empathie, soziale Verantwortung, differenziertes Denkvermögen, Berücksichtigung situativer Gegebenheiten, Kontextualisierung und vieles mehr.

- Die Hacker- und Manipulations-Gefahren sind ebenfalls nicht zu unterschätzen – sie können auch die Demokratie gefährden – die sozialen Medien haben uns schon mehrmals einen Vorgeschmack davon gegeben.

- Der jetzt schon immer mehr abnehmende zwischenmenschliche Dialog könnte weiter reduziert werden

- Chat GPT steht vermutlich erst am Anfang seiner Entwicklung. Was geschieht, wenn der Mensch die Kontrolle verliert und Entscheidungen nicht mehr nachvollzogen werden können?

- Diese Gefahr wird besonders dann gross d.h. nicht mehr beherrschbar, wenn KI sich selbst optimiert und selbstlernend wird und dann auf dem Weg zu einer Superintelligenz ausser Kontrolle geraten könnte.

- Menschliche Intelligenz kann nur noch eingeschränkt beurteilt und auch vorgetäuscht werden

- Es wurde bereits nachgewiesen, dass Chat GPT Quellen frei erfindet, die gar nicht existieren

- Vor allem junge Menschen könnten immer mehr die Fähigkeit verlieren, selbstständig zu denken und Probleme zu lösen. Eine Universität macht wegen ChatGPT bereits keine Bachelorarbeiten mehr

- Was passiert mit uns – gesellschaftlich und politisch – wenn wir nicht mehr wissen, was wahr und was falsch ist und das Vertrauen in die Kommunikation verlieren?

- Zur Intransparenz gehört auch, dass wir nicht wissen, was mit den von Usern eingegebenen Daten geschieht und ob, bzw. wie und wo diese allenfalls kommerziell verwendet werden.

- Der Verlust an Arbeitsplätzen, vor allem Bürojobs, könnte immens sein. Gemäss Studien könnten weltweit 300 Millionen Arbeitsplätze gefährdet sein – selbst juristische und journalistische Berufe.

Wir wiederholen obige Punkte im nachfolgenden Text an einigen Stellen bewusst, um diese näher auszuführen, zu präzisieren oder detaillierter zu betrachten.

Die Grenzen von ChatGPT

Man muss auch die Leistungsfähigkeit, sprich Intelligenzleistung von ChatGPT – zumindest auf dem heutigen Entwicklungsstand – unbedingt relativieren: ChatGPT erbringt keine eigene kreative Intelligenz, sondern wiederkäut – etwas böse ausgedrückt – bestehendes Internet-Wissen und bringt es lediglich in eine dialogfähige, strukturierte und komprimierte Form. Chat GPT ist sozusagen eine Imitations- und Plagiatsmaschine, die mit bereits vorhandenen von Menschen erarbeiteten Daten gefüttert wird – dessen sollte man sich bewusst sein.

Bewusst sein man sich auch, dass ChatGPT nicht zwischen Fakten, Fake und Fiktion unterscheiden kann. Der Mensch ist von Natur aus bequem und delegiert Dinge gerne an Maschinen. Wenn dies mit immer mehr Fragen und Aufgaben geschieht, auch komplizierten Analysen, Entscheidungen mit grosser Tragweite und mehr, steigen auch die Risiken von Fehleinschätzungen.

KI ist maschinelles Lernen, aber keine Intelligenz

Was man sich auch bewusst sein sollte: ChatGPT ist abhängig von der Qualität und Anzahl der Quellen, auf die es zugreift und von den Trainingsdaten, mit denen es gefüttert wird. Sind diese Inhalte falsch oder veraltet, sind es auch die Resultate und Antworten. Streng genommen ist schon der Begriff Intelligenz in der KI nicht korrekt und letztlich ein Marketingterminus. Es handelt sich bei korrekter Beurteilung von ChatGPT viel eher um maschinelles Lernen auf der Basis statistischer Wahrscheinlichkeiten. ChatGPT weiss und versteht nichts – es errechnet nichts anderes als Wortfolgewahrscheinlichkeiten.

ChatGPT reproduziert vorhandene Texte

Was im Internet am häufigsten thematisiert wird und in als vertrauenswürdig geltenden Quellen enthalten ist (Wikipedia, Bücher, Foren), ist für den Chatbot nur deshalb oft auch das Korrekte und Richtige, worauf man sich verlassen kann. Stellt man dem Textgenerator – als den man ChatGPT ja auch bezeichnen kann oder soll – anspruchsvolle Fachfragen oder wünscht sich kreative Lösungen, stösst er schnell an seine Grenzen und bleibt doch recht oberflächlich und plattitüdenhaft – und kann sogar ins Halluzinieren verfallen. Solche Antworten sollte man also immer überprüfen – umso wichtiger sie sind, desto genauer. Die Antworten kommen oft auch sprachlich mechanisch daher, da ChatGPT einem typischen programmierten Antwort-Muster folgt. Die Qualität von Informationen ist allerdings auch abhängig davon, wie genau und klar ein Prompt (Anfrage an ChatGPT) von Nutzern formuliert und strukturiert wird.

Expertenwissen und Kreatives liefert ChatGPT unbefriedigend

Sind Fragen anspruchsvoll oder betreffen komplexe Themen, stösst man ebenso schnell an die Grenzen von ChatGPT. Er ist daher auch nicht fähig, „out of the box“ zu denken und zu argumentieren, sondern reproduziert vorhandene Texte, wie zuvor erwähnt, in der Form statistischer Wahrscheinlichkeiten. Das ist so gesehen streng beurteilt auch keine Intelligenz, auch als künstlich definierte nicht. Problematisch ist natürlich auch, dass einmal mehr Techkonzerne dominieren, welche sich jeder demokratischen und politischen Kontrolle und Verantwortlichkeit entziehen.

Nachlassende Qualität und Zuverlässigkeit

Aktuell nimmt auch die Qualität von Antworten tendenziell ab. Dies hat unter anderem damit zu tun, dass ChatGPT Fakes nicht von Facts unterscheiden kann und sich so immer wieder auch mit eigenen Falschinformationen inzestartig füttert. Deshalb ist es auch nicht erstaunlich, dass die Nutzung von ChatGPT abnimmt.

Problematisch ist auch, dass die KI immer wieder auch (menschliche) Vorurteile widerspiegelt, die im riesigen Datensatz erfasst wurden. Zudem generiert ChatGPT auch bei heiklen Themen durch das recht hohe Sprachniveau plausibel klingende Unwahrheiten, die zur unkritischen Akzeptanz verleiten. Es ist also besonders bei wichtigen Informationen grösste Vorsicht geboten. Wer der KI eine schwierige Frage stellt, ohne die Antwort auf deren Korrektheit zu überprüfen, oder diese anderswo zu verifizieren oder nachzurecherchieren, muss sich bewusst sein, Falschinformationen erhalten zu können.

Worst-Case-Szenario des Missbrauchs

Die gefährlichste Entwicklung und der Worst Case könnte sein, dass wir Wahrheit und Unwahrheit nicht mehr unterscheiden und erkennen können und es keine echten Wahrheiten mehr gibt. ChatGPT ist in der Lage, Fake-Bilder der und Fake-Stimmen zu generieren – und zwar kann dies jeder und man kann es in Massen. Ein Beispiel: die AfD in Deutschland flutet soziale Medien, sie habe die Macht übernommen und geputscht. Ein Fotograf gewann bereits jetzt einen Preis für das beste Foto des Jahres, welches aber von der KI erstellt wurde. Damit wollte er zeigen, dass Wahrheit und Echtheit schon jetzt nicht mehr unterschieden werden. Solche und Tausende anderer möglicher Manipulationen und Täuschungen können im Extremfall Chaos erzeugen, Länder destabilisieren, die Demokratie schädigen und das Vertrauen in die Politik zerstören.

Soll man KI wirklich privaten Techkonzernen überlassen?

Dies ist ein weiterer Aspekt, der unbedingt berücksichtigt werden sollte. Schon der Missbrauch bei sozialen Medien mit Fake News und Manipulationen zeigte, wie schnell auch demokratische Werte gefährdet werden können. Noch stärker gilt dies für eine, wenn sie ausser Kontrolle oder in die Hände diktatorischer Regimes gerät. Überdies sind Techkonzerne weder in der Lage noch legitimiert, über dermassen mächtige Tools mit weitreichenden gesellschaftlichen Auswirkungen zu entscheiden. Die USA sind technologisch absolut führend (was sie auch in der KI wieder beweisen) – aber in ethischen, gesellschaftlichen und sozialen Fragen und Bereichen verfügen sie nicht über die notwendigen Kompetenzen und Handlungsbereitschaft. Dies ist und war auch bei sozialen Medien immer wieder erkennbar. Mit dem Artificial Intelligence Act hat die EU als Erste erkannt, dass man diese nicht den USA überlassen darf und bereits einen Text vorgelegt.

KI muss reglementiert werden

Mit anderen Worten: KI muss reglementiert werden. Ein weiteres Problem ist auch, dass es sich bei den Trainingsdaten überwiegend um amerikanische und europäische Inhalte handelt. Dies hat zur Folge, dass auch die entsprechenden Werte, Weltbilder und Anschauungen entsprechend dominieren. Erste Priorität werden Regulierungen haben müssen, welche nicht die Technologie als solche, sondern die Anwendungen, die Transparenz, die Kontrollen der Entwicklung und mehr zum Thema haben.

Die positiven Aspekte von ChatGPT

Auch wenn man ChatGPT mit kritischer Distanz und notwendiger Skepsis beurteilen und nicht kritiklos dem Hype verfallen sollte, – wie dies zurzeit vielerorts der Fall ist – man darf das riesige Potenzial und den gewaltigen Entwicklungssprung dieser Chatbot-Generation nicht unterschätzen. Auch in den üblichen Kulturpessimismus zu geraten, der nur Gefahren und Risiken, aber nichtht die Chancen und das Potenzial sieht, ist der falsche Weg. Überzeugend und nutzenstiftend sind beispielsweise:

- Das unglaubliche Tempo, mit dem ChatGPT Antworten liefert

- Die erstaunliche Dialogfähigkeit von Antworten und Chats

- Die sprachlich fast immer fehlerfreie Kommunikation

- Der Grad der Korrektheit und Strukturierung der Antworten

- Je nach Fragestellung die Differenzierungsfähigkeit und Objektivität

Es wird am Schluss vermutlich so sein, dass wir diese Entwicklung nicht verbieten und ablehnen sollten (und auch nicht können), sondern lernen müssen, damit umzugehen und den Chatbot als Werkzeug zu sehen, das uns eher unterstützt als bedroht. Nur dieses Lernen wird immer anspruchsvoller und spaltet unsere Gesellschaft wohl noch mehr eine Zweiklassengesellschaft, als dies jetzt schon der Fall ist: Eine Minderheit, die weiss, wie damit umzugehen und ChatGPT zu hinterfragen versteht und eine Mehrheit, die es verlernt zu lernen und das Denken an den Chatbot abdelegiert.

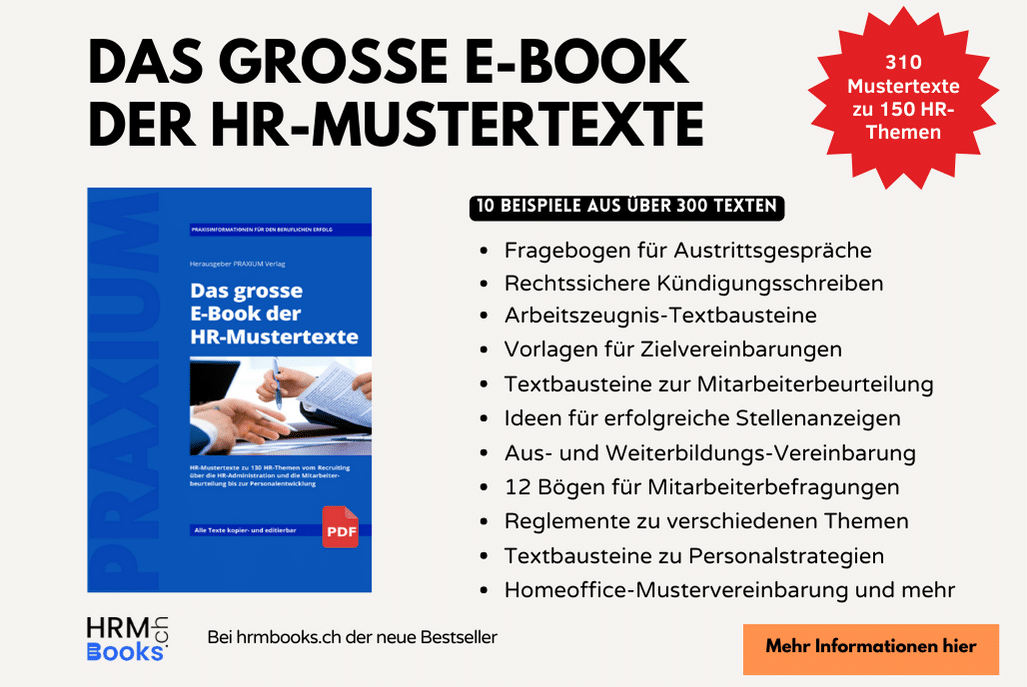

Übrigens: Dieser Text wurde ohne jegliche Assistenz des Chatbots verfasst :-). Wir hoffen, Sie glauben uns das und erkennen anzunehmende Unterschiede. Auch das untenstehende E-Book der HR-Mustertexte wurde übrigens ohne jede ChatGPT-Assistenz verfasst.

Bewerten kann ich das nicht, aber ich bin schlauer bzw. vorsichtiger geworden. Danke dem Autor für diesen Beitrag.

“von denen niemand spricht” und “Nur einmal mehr wird, wie schon bei der Digitalisierung, auch diese KI-Innovation unkritisch gehypt. Welches die zahlreichen Gefahren und Risiken sind und wo Vorsicht geboten ist, verrät dieser Beitrag.”

Sorry, aber das hat nichts mit gutem Journalismus zu tun, sondern mit billigem Clickbaiting. Die Risiken von KI sind in aller Munde.

ChatGPT hätte diesen Artikel weniger emotional aufgepusht und damit letztlich besser geschrieben als der Autor.

Hilfreiche Einschätzung!

Hervorragend!

Weitsichtig!

Danke!

Werden nicht schon seit vielen Jahren mit Textbausteinen kommuniziert, wo mehr oder weniger automatisch auf Kundenanfragen geantwortet wird? Erstellen Schüler und Studenten nicht schon seit dem Googlezeitalter ihre Regerate und Ausarbeitungen durch zusammenkopieren von Texten, die sie im Inteenet finden? Für mich nicht so viel anders als eine Ki, die wie ChatGPT Texte generiert.. man muss es in jedem Fall gut reviewen, über- und bearbeiten.